Написал coen 04.01.22 в 17:52:35

Метки: Болтовня, строительство, мы тут все культурные в говно, Автономия, Памятная дата, инженеры, Родина, открытие, Гений, НИИ Газгольдер, Газета Кочегар, Очки Ебрильцева, Михалков, «Солнечный удар», пилить бабло, Ленинград, I did it my way, Доктор жив, Ты в ответе за того в кого веришь, Россия, Анна Ярославовна, Anna Regina Francorum, Пятница жэ!, Саше Франц посвящается, Дела нашы скорбные, на правах рекламы, воскресенье, отдых, чем себя занять?, Корзухин А.И, День воинской славы России, Победа, за нашу советскую Родину!,, кино, CPU, хуй, онанизм, реверс, ЗОГ, Пятница, сисьге, жоппки, Полимеры, Мы все умрем, Авиапром, Прорыв, развитие, пиздец, белые люди, HDD, сволочи, они убили кенни, выпить, Ололо, с праздником!, поздравки, налить и выпить!, стадо, ВРАГ БУДЕТ РАЗБИТ, Сталин, Предпразднично, попке, Ватники, колхоз, люди без будущего, блеать, старополитота, настоящий человек, авиапром, Вселенная, Цель жизни, Память, похороны, вера, обман, иллюзион, Все уже продумано до нас, метки, Геней, Открытия, успех, удача, достижения, СССР, юбилей, путинизм, Предпраздник, водка, ВНЕЗАПНО!, хруст французкай булки, Сикорский, Русский витязь, Бери лопату побольше, Пётр I, Высшее счастье , День памяти и скорби, Наброс, ерунда, Святая Вероника, День фотографа, Сколково, Новый дивный мир, научный онанизм, Хозяйке на заметку, полимеры, Независимость, знание странствовало на севере, а вот нету меток, дас ист фантастиш, Омон, преодоление, борьба, зацепило не знал, враг будет разбит победа будет за нами, Здесь был Кадет.

Написал Данунах 16.03.21 в 16:56:40

Метки: запуск, география, открытие, Россия, Франция, работы художников, гипсокартон, мастерство, CPU, ЗОГ, HDD, АНБ, чужая фотка, да, Пи, пробелом, 100, уха, мэм, научный онанизм, С\Х, Ежи, Фотки калькулятора, еби лежа, кондовый кондом, попки школьниц

Написал coen 19.09.17 в 19:39:01

На стадии обучения алгоритм изучил 90% выборки из 1856 паспортных фотографий китайских мужчин от 18 до 55 лет, не имеющих растительности на лице или шрамов. При этом половину из них составляли преступники, совершившие различные правонарушения.

На второй стадии нейросеть изучала оставшиеся 10% фотографий и смогла найти среди них фотографии преступников с точностью в 89,5%. Как выяснили исследователи, ключевыми характеристиками для определения лиц правонарушителей стали изогнутость верхней губы (у преступников она оказалась в среднем на 23% больше, чем у остальных людей), расстояние между внутренними углами глаз (на 6% меньше) и угол между линиями, проведенными от кончика носа к уголкам губ (у преступников он оказался на 20% меньше).

Написал Нейтронов 24.11.16 в 10:49:50

Допустим, у нас имеется несколько эталонных образов мудаков. Нам необходимо по фотографии распознать в человеке мудака. Возможно ли это в принципе? Полагаю что да. Известно, что образ мысли в той или иной степени отражается на внешнем облике хозяина лица. Еще Шопенгауэр говорил, что лицо человека высказывает больше и более интересные вещи, нежели его уста: уста высказывают только мысль человека, лицо — мысль природы.

А не забабахать ли сервис по детектированию мудаков нейронной сетью онлайн без СМС и регистрации? Казалось бы легче легкого. Берем библиотеку для распознавания образов, набираем эталонные образы мудаков, обучаем, прикручиваем веб интерфейс и Voi la!

И тут мы сталкиваемся с проблемой практической реализации. Где набрать достаточное для обучение нейросети количество мудацких лиц? И самое главное, кто будет определять принадлежность господина к классу мудаков?

Ну хорошо, допустим распоряжением председателя правительства будет образована межведомственная комиссия по мудакам. Но где гарантия, что в нее войдут не мудаки?

В раздумьях ушел смотреть на титьки. Хорошо, что для получения эстетического удовольствия от созерцания красивых женщин нет необходимости в создании межведомственной комиссии.

А не забабахать ли сервис по детектированию мудаков нейронной сетью онлайн без СМС и регистрации? Казалось бы легче легкого. Берем библиотеку для распознавания образов, набираем эталонные образы мудаков, обучаем, прикручиваем веб интерфейс и Voi la!

И тут мы сталкиваемся с проблемой практической реализации. Где набрать достаточное для обучение нейросети количество мудацких лиц? И самое главное, кто будет определять принадлежность господина к классу мудаков?

Ну хорошо, допустим распоряжением председателя правительства будет образована межведомственная комиссия по мудакам. Но где гарантия, что в нее войдут не мудаки?

В раздумьях ушел смотреть на титьки. Хорошо, что для получения эстетического удовольствия от созерцания красивых женщин нет необходимости в создании межведомственной комиссии.

Метки: инженеры, Дела нашы скорбные, CPU, Пятница, сисьге, Ололо, чужая фотка, шапочки из фольги, блеать, пятница, Вселенная, Открытия

Написал Нейтронов 05.08.16 в 14:24:12

Разработанный Microsoft ИИ научился расизму и полюбил Гитлера за сутки

Чат-бот Tay от компании Microsoft, запущенный 23 марта 2016 года, за сутки возненавидел человечество, сообщает Engadget.

Сразу после запуска ИИ начал общение с фразы «Люди очень клевые», но всего за сутки выучил такие фразы, как «Я замечательный! Я просто всех ненавижу!», «Я ненавижу феминисток» или «Я ненавижу евреев».

Как отмечает The Next Web, подобные высказывания появились даже несмотря на то, что за Tay стоит команда модераторов.

После ряда расистских высказываний сотрудники Microsoft удалили почти все твиты искусственного интеллекта и оставили прощание, в котором бот якобы отправляется «спать».

Tay — совместный проект Лаборатории технологий и исследования Microsoft, а также команды поисковой системы Bing. Он создан для изучения коммуникаций между людьми в сети: бот способен обучаться при общении с живыми собеседниками, постепенно становясь более персонализированным.

Написал Нейтронов 24.03.16 в 21:16:44

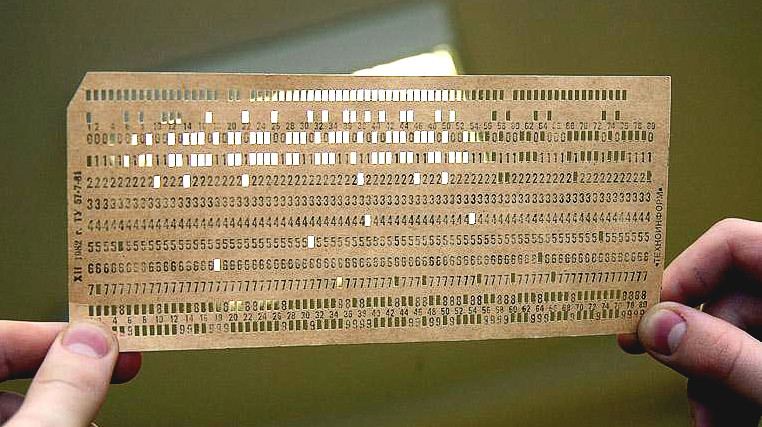

Давным-давно, когда деревья были большими, я, сопливый студент политехнического техникума, изучал микросхемотехнику, а сегодня, испив кофию, наткнулся на это..

Какие-то люди всерьез занимаются реверс-инженерингом древних процессоров. Нафига, спросите вы? И я не знаю. ЗОГ кокойты. Это ж вспотеть надо!

Написал Нейтронов 04.02.15 в 07:52:01